L’industrie automobile s’orientant de plus en plus vers la conduite autonome, le rôle de la vision embarquée dans les systèmes avancés d’aide à la conduite (ADAS) évolue. Les fabricants d’équipements d’origine doivent se préparer à passer des systèmes assistés aux systèmes automatisés. Cela représente des défis technologiques pour les ingénieurs qui développent des solutions pour l’aide à la conduite avancée et la conduite autonome.

Dans cet article, nous allons voir comment les capteurs de perception des véhicules (ADAS) rendent possible l’automatisation.

Nous examinerons également certains des défis à relever.

De quelle façon les capteurs et les systèmes embarqués rendent-ils possible l’aide avancée à la conduite?

L’objectif d’accroître la

sécurité routière repose essentiellement sur les progrès constants de la technologie des capteurs. De quelle façon? Les fonctions d’un système avancé d’aide à la conduite reposent sur des données provenant de capteurs. Le système se sert des capteurs pour avertir les conducteurs des risques et pour intervenir afin d’éviter les accidents. Certains véhicules intègrent le système avancé d’aide à la conduite au système d’infodivertissement pour offrir aux conducteurs une vue de leur environnement.

Le système avancé d’aide à la conduite (ADAS) se sert de

systèmes embarqués installés dans tout le véhicule. Les caméras, la détection et télémétrie par radioélectricité (radar), la détection et télémétrie par laser (lidar) et les transducteurs ultrasoniques jouent tous un rôle dans la collecte des données. Le système mondial de navigation par satellite (GNSS) et les unités de mesure inertielle (IMU) fournissent des données supplémentaires. Le défi consiste à interpréter les données en temps réel à partir de la vision embarquée pour permettre au système d’intervenir.

À cette fin, les systèmes avancés d’aide à la conduite modernes ont besoin d’une puissance de calcul et d’une mémoire plus importantes pour traiter les multiples flux de données. De nouvelles technologies, développées au cours de la dernière année, ont fait progresser la perception des véhicules de pointe. Ces systèmes utilisent des unités centrales graphiques (GPU), des matrices prédiffusées programmables par l’utilisateur (FPGA) ou des circuits intégrés à application spécifique (ASIC) personnalisés à l’intérieur d’unités de contrôle électronique (ECU) pour effectuer efficacement le traitement graphique et des images et traiter de grands volumes de données en temps réel.

Les ECU sont le cerveau qui contrôle la fusion des données de capteurs automobiles. De quelle façon? Le contrôleur ADAS fusionne les données des différents capteurs pour prendre des décisions. Les systèmes informatiques utilisent différentes caméras pour alerter le conducteur en cas de danger grâce à des avertisseurs d’angle mort, de changement de voie et de collision, tandis que des radars et d’autres capteurs à différents niveaux aident à cartographier l’environnement et à prendre des mesures.

L’évolution des capteurs dans les systèmes avancés d’aide à la conduite (ADAS)

Le document de normes de la Society of Automotive Engineers (SAE),

SAE J3016 est une référence utile qui définit les niveaux des systèmes d’automatisation de la conduite des véhicules à moteur routiers. Les niveaux d’automatisation de la conduite sont définis en fonction du rôle joué par chacun des trois principaux acteurs de l’exécution : l’utilisateur (l’être humain), le système d’automatisation de la conduite et les autres systèmes et composants du véhicule. Les niveaux 1, 2 et 3 nécessitent la présence d’un conducteur humain. À ces niveaux, le conducteur humain et le système d’automatisation de la voiture sont censés travailler main dans la main pendant la conduite. Les niveaux 4 et 5 font référence à de véritables voitures autopilotées dotées d’une intelligence artificielle (AI) et ne nécessitant aucune assistance humaine pendant la conduite.

La dernière génération de véhicules va au-delà du niveau d’autonomie 0 à 2 en fournissant une aide au conducteur, notamment des avertissements et des interventions d’assistance brèves, comme l’avertisseur d’angle mort, le freinage d’urgence automatique ainsi que le centrage sur la voie et le régulateur de vitesse adaptatif.

Les niveaux 3 à 4 permettent d’accéder aux fonctions de conduite automatisée, qui peuvent prendre le contrôle du véhicule dans des conditions précises. Les ECU utilisent la vision embarquée pour permettre aux véhicules de prendre instantanément des décisions en matière de sécurité. De quelle façon? Les données fournies par les capteurs, les cartes et les données de circulation en temps réel permettent aux ECU d’anticiper les problèmes sur la route.

Avec davantage de capteurs intégrés au véhicule, le système peut combiner des données historiques et en temps réel sur l’état des voies de circulation. Cela lui permet non seulement d’informer le conducteur, mais aussi d’agir. Des algorithmes d’apprentissage profond de vision par ordinateur sont utilisés pour former des modèles de réseaux neuronaux. Ces modèles sont formés et affinés en permanence à l’aide de scènes routières et de simulateurs. L’inférence en temps réel utilise ces modèles pour détecter, classer et suivre des objets tels que des vélos et des piétons dans le champ de vision du véhicule. Le système dispose alors de suffisamment de données sur le conducteur et son environnement pour prendre le contrôle, que ce soit pour éviter un danger ou simplement pour faire un stationnement automatique.

Comme les véhicules sont dotés d’une grande variété de services compatibles avec la 4G destinés au conducteur et aux passagers, les systèmes avancés d’aide à la conduite peuvent également être considérés comme une passerelle vers la conduite entièrement autonome avec la mise en œuvre de la 5G et de la connectivité en temps réel qui se combinent aux capteurs embarqués avancés (radar, lidar, caméras).

Il reste encore du travail à faire pour parvenir à une autonomie totale et voir l’arrivée d’une voiture possédant une autonomie de conduite de niveau 5. Les changements dans la disposition et l’intégration des capteurs se feront progressivement et seront tributaires des progrès de ces technologies et de la réduction des coûts.

Combiner les capteurs et la technologie : un défi pour le développement des véhicules

Les véhicules actuellement sur le marché sont de plus en plus intelligents et sûrs. Ils sont dotés des trois principaux types de capteurs :

caméras, radar et lidar. Grâce aux capteurs couplés à un puissant système informatique, le véhicule peut cartographier l’environnement qui l’entoure, le comprendre et s’y déplacer en toute sécurité. Chaque capteur a ses avantages et ses inconvénients. Quelles sont les différences fondamentales entre ces trois types de capteurs? Jetons un coup d’œil.

Caméras

Bien que les caméras détectent les données RVB (rouge, vert, bleu) et offrent une résolution extrêmement élevée, elles ne disposent pas de données sur la profondeur, ne perçoivent pas la vitesse et peuvent être aveuglées par la lumière du soleil. Elles nécessitent également une puissance de calcul beaucoup plus importante et doivent être combinés avec les capteurs radar et lidar en technologie complémentaire pour optimiser l’analyse de toutes les données.

Radar

Communément associé aux caméras, le radar peut contribuer à réduire le nombre d’images vidéo nécessaires au véhicule pour détecter le danger et y réagir. Il offre des avantages sur les plans de la vitesse et de la détection des objets, sans compter sa capacité à percevoir ce qui se trouve autour des objets et à fonctionner par mauvais temps. Mais il n’est pas assez précis pour déterminer si ce qu’il perçoit est un piéton, une voiture ou un autre objet.

Lidar

Disposé dans l’ensemble du véhicule, le lidar complète les caméras et le radar en offrant une couverture de 360 degrés, ainsi que la possibilité de réaliser une détection très fine et précise des objets dans l’espace. Mais le lidar n’a pas une résolution comparable à celle d’une caméra 2D, et présente des limites dans de mauvaises conditions météorologiques. En outre, il ne détecte pas les couleurs ni ne sait interpréter du texte afin, par exemple, de décoder des feux de signalisation ou des panneaux. Le coût d’intégration de solutions lidar aux systèmes avancés d’aide à la conduite se révèle également problématique. L’émergence de technologies efficaces et de

solutions innovantes a récemment ouvert la voie à des concepts abordables d’intégration de l’imagerie 3D en haute résolution à l’industrie automobile.

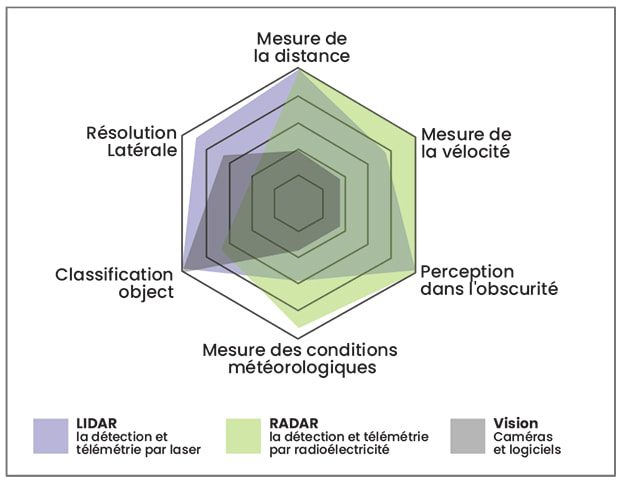

Différences fondamentales entre LiDAR, RADAR et VISION

Différences fondamentales entre LiDAR, RADAR et VISION

GNSS

Au-delà des caméras, des radars et des lidars, d’autres systèmes jouent un rôle important et peuvent aider à relever les enjeux du développement de la sécurité des applications ADAS. Un véhicule entièrement autonome doit disposer d’une solution de localisation précise. Les données au sol, la cartographie mobile et la géolocalisation en temps réel sont essentielles. La technologie GNSS de haute précision offre l’exactitude, la disponibilité et la fiabilité nécessaires à la conduite autonome d’un véhicule.

Une combinaison de technologies alliant un système radar/lidar à des caméras et à une solution GNSS offre sûrement le meilleur moyen d’obtenir la performance de géolocalisation requise par les véhicules de niveaux d’autonomie 4 ou 5.

L’avenir des systèmes embarqués dans les systèmes ADAS

La plupart des véhicules fabriqués dans le monde possèdent un certain niveau d’automatisation de la conduite. Les systèmes avancés d’aide à la conduite (ADAS) forment l’un des segments de l’électronique automobile qui connaît la croissance la plus rapide. Pour demeurer concurrentielles, les équipes de développement doivent avoir l’expérience nécessaire pour fournir des solutions de haute qualité, à faible risque, et comprendre le fonctionnement des technologies des capteurs pour que le véhicule puisse réagir à tout ce qui se passe dans son environnement et offrir une expérience utilisateur améliorée.

Chez Orthogone, nous possédons l’expertise requise pour mettre au point un véhicule sûr et intelligent.

Nous travaillons en partenariat avec des constructeurs et des fournisseurs automobiles pour concevoir des systèmes de haute performance et nous comprenons le défi grandissant que représente l’utilisation de systèmes embarqués dans les systèmes ADAS.

Communiquez avec nous dès aujourd’hui pour savoir de quelle façon Orthogone peut travailler avec vous à votre projet de systèmes embarqués automobiles.

Différences fondamentales entre LiDAR, RADAR et VISION

Différences fondamentales entre LiDAR, RADAR et VISION